提到hash,相信大大都同窗都不会目生,之前很火如今也照旧很火的手艺区块链背后的底层原理之一就是hash,下面就从hash算法的原理和现实应用等几个角度,对hash算法停止一个讲解。1、什么是Hash

Hash也称散列、哈希,对应的英文都是Hash。根本原理就是把肆意长度的输入,通过Hash算法酿成固定长度的输出。那个映射的规则就是对应的Hash算法,而原始数据映射后的二进造串就是哈希值。活动开发中经常利用的MD5和SHA都是汗青悠久的Hash算法。

echo md5("那是一个测试案牍"); // 输出成果:2124968af757ed51e71e6abeac04f98d在那个例子里,那是一个测试案牍是原始值,2124968af757ed51e71e6abeac04f98d 就是颠末hash算法得到的Hash值。整个Hash算法的过程就是把原始肆意长度的值空间,映射成固定长度的值空间的过程。

2、Hash的特点一个优良的hash算法,需要什么样的要求呢?

a)、从hash值不成以反向推导出原始的数据

那个从上面MD5的例子里能够明白看到,颠末映射后的数据和原始数据没有对应关系b)、输入数据的细小变革会得到完全差别的hash值,不异的数据会得到不异的值

echo md5("那是一个测试案牍");

// 输出成果:2124968af757ed51e71e6abeac04f98d

echo md5("那是二个测试案牍");

// 输出成果:bcc2a4bb4373076d494b2223aef9f702能够看到我们只改了一个文字,但是整个得到的hash值产生了十分大的变革。c)、哈希算法的施行效率要高效,长的文本也能快速地计算出哈希值d)、hash算法的抵触概率要小

因为hash的原理是将输入空间的值映射成hash空间内,而hash值的空间远小于输入的空间。按照抽屉原理,必然会存在差别的输入被映射成不异输出的情况。那么做为一个好的hash算法,就需要那种抵触的概率尽可能小。桌上有十个苹果,要把那十个苹果放到九个抽屉里,无论如何放,我们会发现至少会有一个抽屉里面放很多于两个苹果。那一现象就是我们所说的“抽屉原理”。抽屉原理的一般含义为:“若是每个抽屉代表一个集合,每一个苹果就能够代表一个元素,假设有n+1个元素放到n个集合中去,此中肯定有一个集合里至少有两个元素。” 抽屉原理有时也被称为鸽巢原理。它是组合数学中一个重要的原理3、Hash碰碰的处理计划前面提到了hash算法是必然会有抵触的,那么若是我们若是碰到了hash抵触需要处理的时候应该怎么处置呢?比力常用的算法是链地址法和开放地址法。

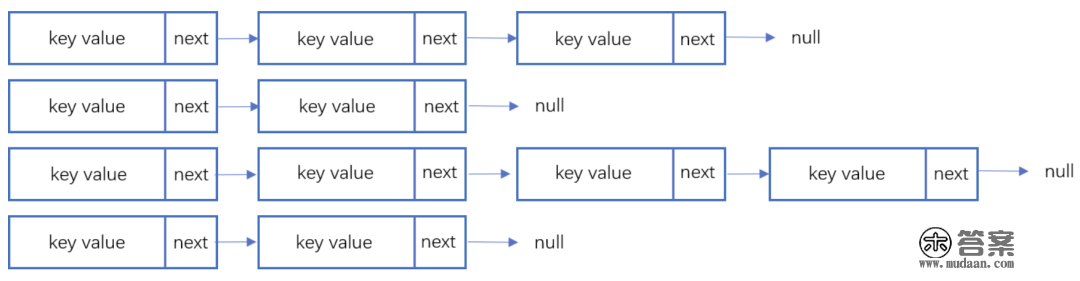

3.1 链地址法链表地址法是利用一个链表数组,来存储响应数据,当hash碰到抵触的时候依次添加到链表的后面停止处置。

链地址在处置的流程如下:

添加一个元素的时候,起首计算元素key的hash值,确定插入数组中的位置。若是当前位置下没有反复数据,则间接添加到当前位置。当碰到抵触的时候,添加到统一个hash值的元素后面,行成一个链表。那个链表的特点是统一个链表上的Hash值不异。java的数据构造HashMap利用的就是那种办法来处置抵触,JDK1.8中,针对链表上的数据超越8条的时候,利用了红黑树停止优化。因为篇幅原因,那里不深切讨论相关数据构造,有兴趣的同窗能够参考那篇文章:《Java集合之一—HashMap》

3.2 开放地址法开放地址法是指大小为 M 的数组保留 N 个键值对,此中 M > N。我们需要依靠数组中的空位处理碰碰抵触。基于那种战略的所有办法被统称为“开放地址”哈希表。线性探测法,就是比力常用的一种“开放地址”哈希表的一种实现体例。线性探测法的核心思惟是当抵触发作时,挨次查看表中下一单位,曲到找出一个空单位或查遍全表。简单来说就是:一旦发作抵触,就去寻找下 一个空的散列表地址,只要散列表足够大,空的散列地址总能找到。

线性探测法的数学描述是:h(k, i) = (h(k, 0) + i) mod m,i暗示当前停止的是第几轮探查。i=1时,便是探查h(k, 0)的下一个;i=2,便是再下一个。那个办法是简单地向下探查。mod m暗示:抵达了表的底下之后,回到顶端从头起头。

关于开放寻址抵触处理办法,除了线性探测办法之外,还有别的两种比力典范的探测办法,二次探测(Quadratic probing)和双重散列(Double hashing)。但是不管接纳哪种探测办法,当散列表中空闲位置不多的时候,散列抵触的概率就会大大进步。为了尽可能包管散列表的操做效率,一般情况下,我们会尽可能包管散列表中有必然比例的空闲槽位。我们用拆载因子(load factor)来暗示空位的几。

散列表的拆载因子=填入表中的元素个数/散列表的长度。拆载因子越大,申明抵触越多,性能越差。

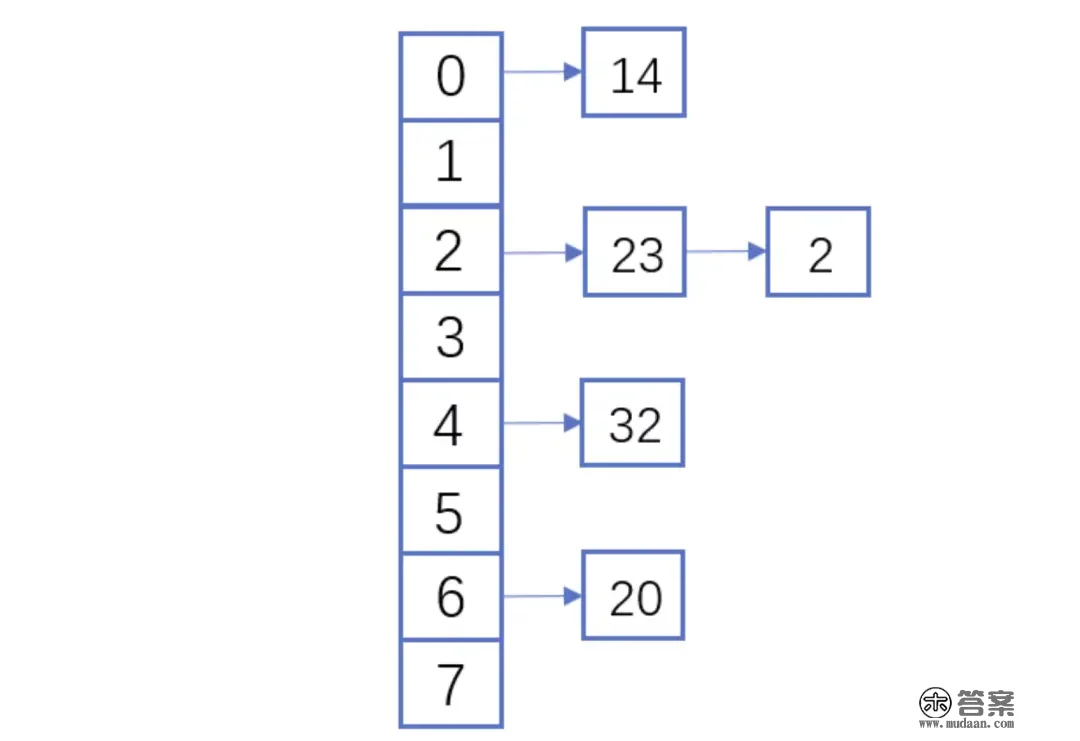

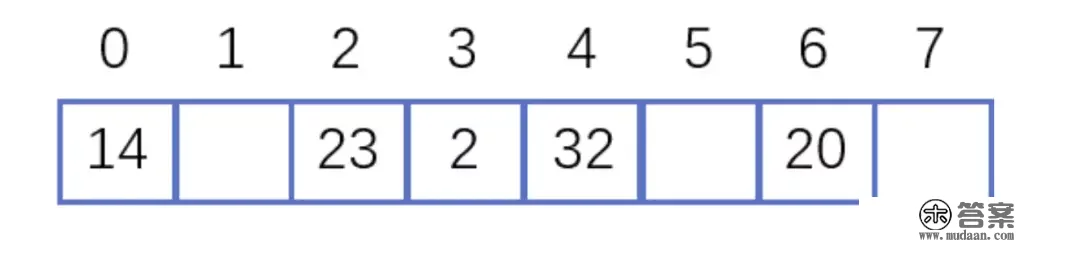

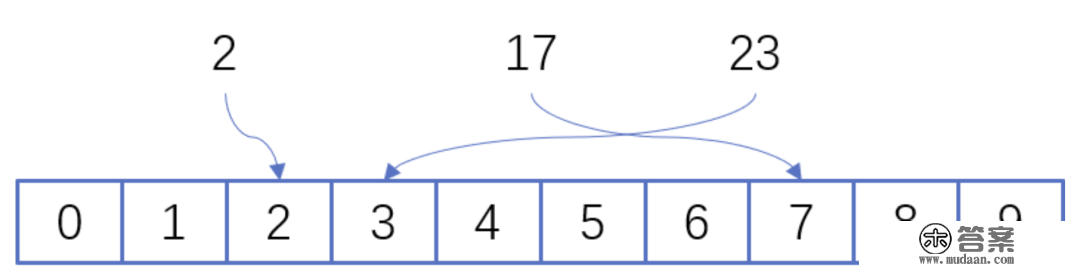

3.3 两种计划的demo示例假设散列长为8,散列函数H(K)=K mod 7,给定的关键字序列为{32,14,23,2, 20}

当利用链表法时,响应的数据构造如下图所示:

当利用线性探测法时,响应的数据成果如下图所示:

那里的两种算法的区别是2那个元素,在链表法中仍是在节点2的位置上,但是在线性探测法碰到抵触时会将抵触数据放到下一个空的位置下面。

4、hash算法在日常活动中的应用在日常运营活动中,我们活动开发经常碰到的应用场景是信息加密、数据校验、负载平衡。下面别离对那三种应用场景停止讲解。

4.1 信息加密起首我们看一下信息加密的应用。2011年CSDN脱库事务,招致超越600W的用户的密码泄露,让人绝望的是,CSDN是明文存储用户的注册邮箱和密码的。做为用户的十分隐私的信息,最简单的庇护办法就是对密码停止hash加密。在客户端对用户输入的密码停止hash运算,然后在办事端的数据库中保留用户密码的hash值。因为办事器端也没有存储密码的明文,所以目前良多网站也就不再有找回密码的功用了。

那里也友情提醒一下各人:若是在利用中发现某网站还有供给找回密码的功用,就要好好担忧下那个网站的平安性了。看到那里有些同窗会觉得那么我们是不是对用户输入的密码停止一次MD5加密就能够了呢,如许就算歹意用户晓得了hash值,也没有法子拿到用户的实在密码。假设用户的密码是123456789,颠末一次md5以后得到的值是:

25f9e794323b453885f5181f1b624d0b

那么是不是利用了那个加密后的字符串来存密码就满有把握了呢,抱负老是很饱满,而现实老是很骨感的。

各人能够看一下那个网站:

https://www.cmd5.com/

那里是该网站的相关介绍:

本站针对md5、sha1等全球通用公开的加密算法停止反向查询,通过穷举字符组合的体例,创建了明文密文对应查询数据库,创建的记录约90万亿条,占用硬盘超越500TB,查询胜利率95%以上,良多复杂密文只要本站才可查询。已不变运行十余年,国表里享有盛誉

那么一般针对那种问题,我们的处理之道就是引入salt(加盐),即操纵特殊字符(盐)和用户的输入合在一路构成新的字符串停止加密。通过如许的体例,增加了反向查询的复杂度。但是如许的体例也不是满有把握,若是发作了盐被泄露的问题,就需要所有用到的处所来重置密码。

针对salt泄露的问题,其实还有一种处理法子,即便用HMAC停止加密(Hash-based Message Authentication Code)。那种算法的核心思绪是加密利用的key是从办事器端获取的,每一个用户的是纷歧样的。若是发作了泄露,那么也就是那一个用户的会被泄露,不会影响到全局。

那里也留给各人一个思虑点,若是歹意用户间接抓取了你的活动参与链接,也就是拿到了你计算后的hash值,那从手艺的角度上说,我们还有没有其他能够提拔歹意用户的违法成本呢?

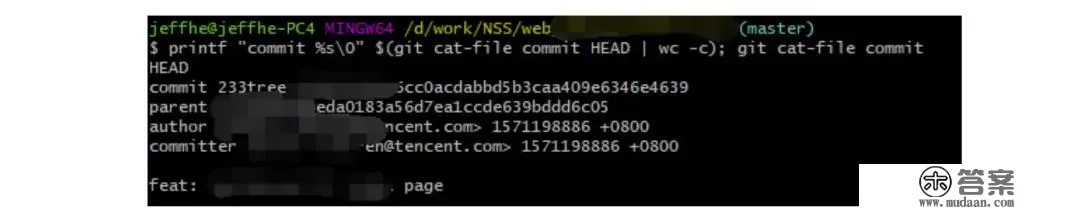

4.2 数据校验- git commit id

利用过git的同窗都应该清晰,每次git提交后都有一个commit id,好比:19d02d2cc358e59b3d04f82677dbf3808ae4fc40

就是一次git commit的成果,那么那个id是若何生成出来的呢?查阅了相关材料,利用如下代码能够停止查看:

printf "commit %s\0" $(git cat-file commit HEAD | wc -c); git cat-file commit HEADgit的commit id次要包罗了以下几部门内容:Tree 哈希,parent哈希、做者信息和本次提交的备注。

针对那些信息停止SHA-1 算法后得到值就是本次提交的commit id。简单来讲,就是关于单次提交的头信息的一个校验和。

Linux kernel创始者和Git的开发者——Linus说,Git利用了sha1并不是是为了平安性,而是为了数据的完好性;它能够包管,在良多年后,你从头checkout某个commit时,必然是它多年前的其时的形态,完全一摸一样,完全值得信赖。但最新研究表白,理论上对其停止哈希碰碰(hash collision,差别的两块数据有不异的hash值)的攻击能够在2^51(2的51次方)摆布的次数内实现。不外因为commit id 是针对单个仓库里的,所以现实应用中我们能够认为若是两个文件的SHA-1值是不异的,那么它们却是完全不异的内容。

注:关于git里tree、parent等构造感兴趣的同窗,能够参考下那篇文章《Git 内部原理 - Git 对象》,那里因为篇幅原因就不停止深切阐发了。

版权校验

在数据校验方面的另一个应用场景就是版权的庇护或者违禁信息的冲击,好比某个小视频,第一个用户上传的时候,我们认为是版权所有者,计算一个hash值存下来。当第二个用户上传的时候,同样计算hash值,若是hash值一样的话,就算统一份文件。那种计划其实也给用户传布违禁文件进步了一些门槛,不是简单的换一个名字或者改一下后缀名就能够遁藏掉冲击了。(当然那种体例也是能够绕过的,图片的你随意改一下颜色,视频去掉一帧就又是完全差别的hash值了。留意:我没有教你变坏,我只是和你在讨论那个手艺。。。)别的我们在社区里,也会碰到玩家反复上传统一张图片或者视频的情况,利用那种校验的体例,能够有效削减cos办事的存储空间。大文件分块校验

利用过bt的同窗都有经历,在p2p收集中会把一个大文件拆分红良多小的数据各自传输。如许的益处是若是某个小的数据块在传输过程中损坏了,只要从头下载那个块就好。为了确保每一个小的数据块都是发布者本身传输的,我们能够对每一个小的数据块都停止一个hash的计算,维护一个hash List,在收到所有数据以后,我们关于那个hash List里的每一块停止遍历比对。那里有一个优化点是若是文件分块出格多的时候,若是遍历比照就会效率比力低。能够把所有分块的hash值组合成一个大的字符串,关于那个字符串再做一次Hash运算,得到最末的hash(Root hash)。在现实的校验中,我们只需要拿到了准确的Root hash,即可校验Hash List,也就能够校验每一个数据块了。 4.3 负载平衡

4.3 负载平衡活动开发同窗在应对高星级营业大用户量参与时,城市利用分库分表,针对用户的openid停止hashtime33取模,就能够得到对应的用户分库分表的节点了。

如上图所示,那里其实是分了10张表,openid计算后的hash值取模10,得到对应的分表,在停止后续处置就好。关于一般的活动或者系统,我们一般设置10张表或者100张表就好。

下面我们来看一点复杂的问题,假设我们活动初始分表了10张,运营一段时间以后发现需要10张不敷,需要改到100张。那个时候我们若是间接扩容的话,那么所有的数据都需要从头计算Hash值,大量的数据都需要停止迁徙。若是更新的是缓存的逻辑,则会招致大量缓存失效,发作雪崩效应,招致数据库异常。形成那种问题的原因是hash算法自己的缘故,只如果取模算法停止处置,则无法制止那种情况。针对那种问题,我们就需要操纵一致性hash停止响应的处置了。

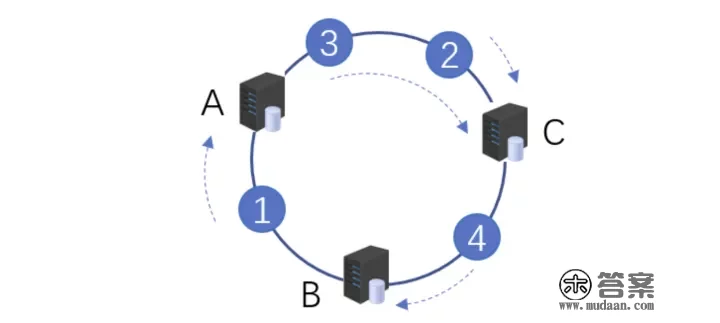

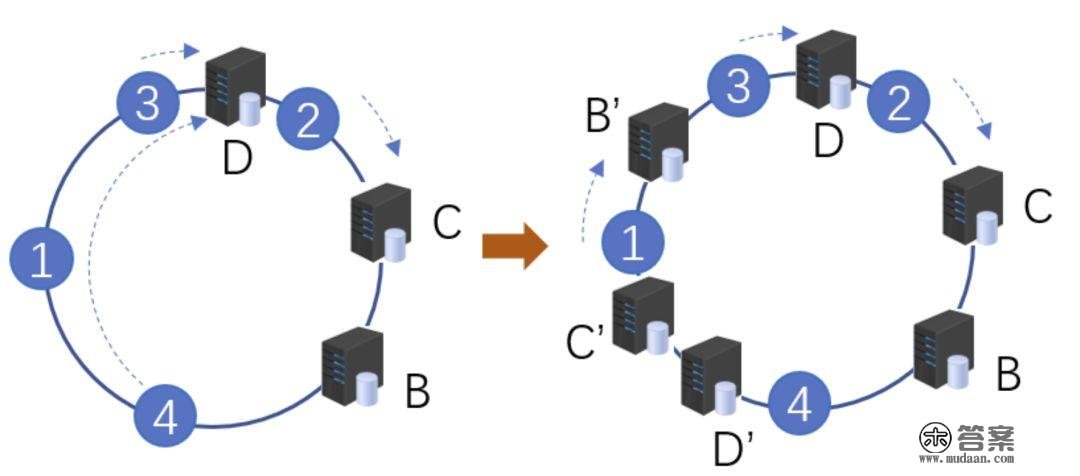

一致性hash的根本原理是将输入的值hash后,对成果的hash值停止2^32取模,那里和通俗的hash取模算法纷歧样的点是在一致性hash算法里将取模的成果映射到一个环上。将缓存办事器与被缓存对象都映射到hash环上以后,从被缓存对象的位置动身,沿顺时针标的目的碰到的第一个办事器,就是当前对象将要缓存于的办事器,因为被缓存对象与办事器hash后的值是固定的,所以,在办事器稳定的情况下,一个openid肯定会被缓存到固定的办事器上,那么,当下次想要拜候那个用户的数据时,只要再次利用不异的算法停止计算,即可算出那个用户的数据被缓存在哪个办事器上,间接去对应的办事器查找对应的数据即可。那里的逻辑其实和间接取模的是一样的。如下图所示:

初始情况如下:用户1的数据在办事器A里,用户2、3的数据存在办事器C里,用户4的数据存储在办事器B里

下面我们来看一下当办事器数量发作变革的时候,响应影响的数据情况:

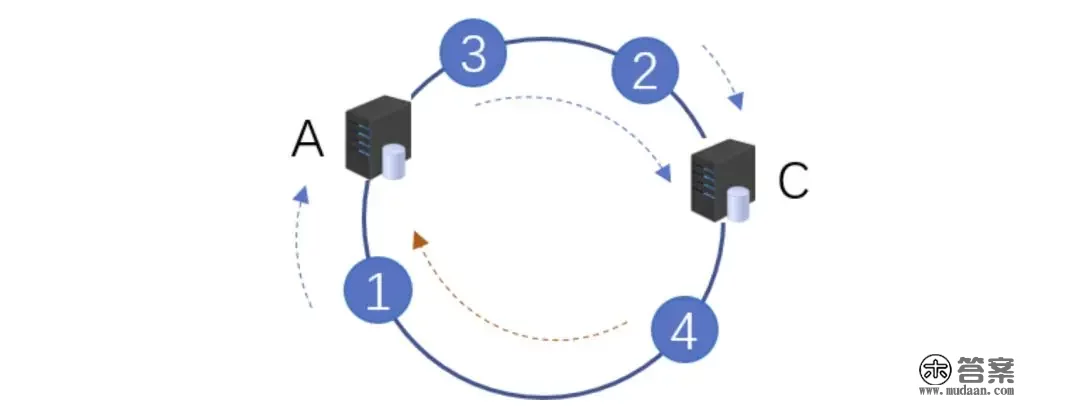

办事器缩容

办事器B发作了毛病,停止剔除后,只要用户4的数据发作了异常。那个时候我们需要继续根据顺时针的计划,把缓存的数据放在用户A上面。

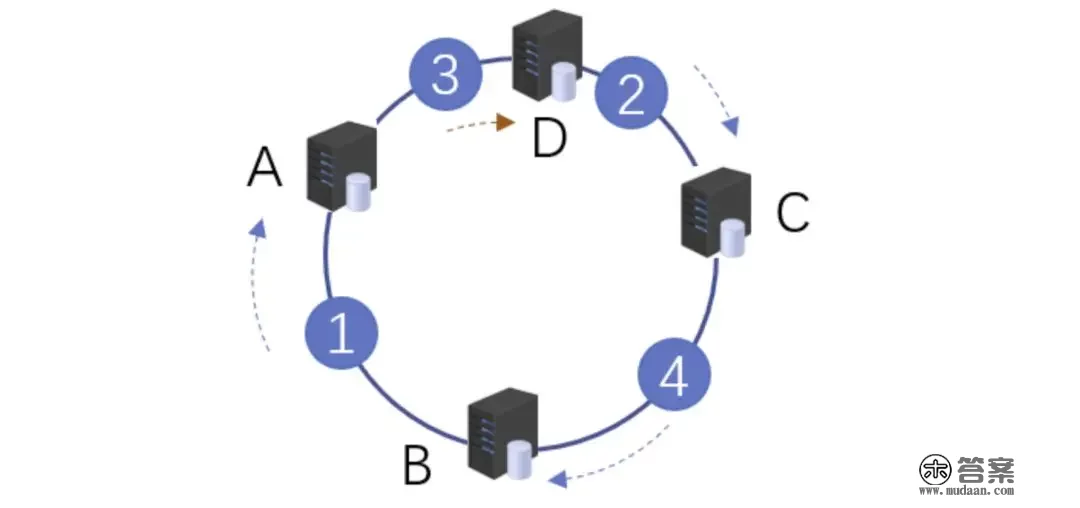

办事器扩容

同样的,我们停止了办事器扩容以后,新增了一台办事器D,位置落在用户2和3之间。根据顺时针原则,用户2仍然拜候的是办事器C的数据,而用户3顺时针查询后,发现比来的办事器是D,后续数据就会存储到d上面。

虚拟节点

当然那只是一种抱负情况,现实利用中,因为办事器节点数量有限,有可能呈现散布不平均的情况。那个时候会呈现大量数据都被映射到某一台办事器的情况,如下图左侧所示。为领会决那个问题,我们接纳了虚拟节点的计划。虚拟节点是现实节点(现实的物理办事器)在hash环上的复成品,一个现实节点能够对应多个虚拟节点。虚拟节点越多,hash环上的节点就越多,数据被平均散布的概率就越大。

如右图所示,B、C、D 是原始节点复造出来的虚拟节点,本来都要拜候机器D的用户1、4,别离被映射到了B,D。通过如许的体例,起到了一个办事器平均散布的感化。

5、几种hash算法的扩展应用下面介绍几种各人可能不经常碰到的应用,因为篇幅原因,不做深切介绍,只抛砖引玉。

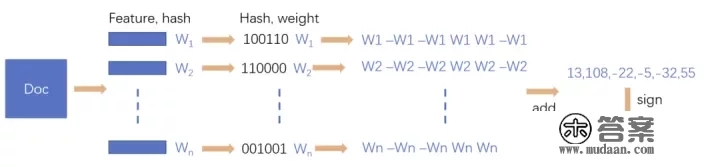

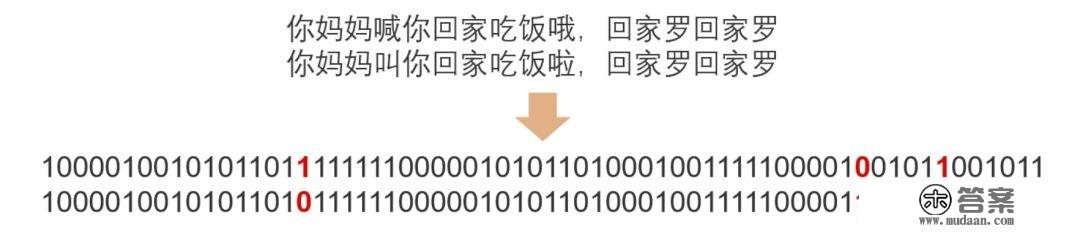

5.1 SimHashsimHash是google用于海量文本去重的一个办法,它是一种部分敏感hash。那什么叫部分敏感呢,假定两个字符串具有必然的类似性,在hash之后,仍然能连结那种类似性,就称之为部分敏感hash。通俗的hash是不具有那种属性的。simhash被Google用来在海量文本中去重。

simHash算法的思绪大致如下:

将Doc停止关键词抽取(此中包罗分词和计算权重),抽取出n个(关键词,权重)对, 即图中的多个(feature, weight)。记为 feature_weight_pairs = [fw1, fw2 … fwn],此中 fwn = (feature_n,weight_n)。对每个feature_weight_pairs中的feature停止hash。然后对hash_weight_pairs停止位的纵向累加,若是该位是1,则+weight,若是是0,则-weight,最初生成bits_count个数字,大于0标识表记标帜1,小于0标识表记标帜0最初转换成一个64位的字节,判断反复只需要判断他们的特征字的间隔是不是<n (n按照经历一般取3),就能够判断两个文档能否类似。

如下图所示,当两个文本只要一个字变革时,若是利用通俗Hash则会招致两次的成果发作较大改动,而SimHash的部分敏感特征,会招致只要部门数据发作变革。

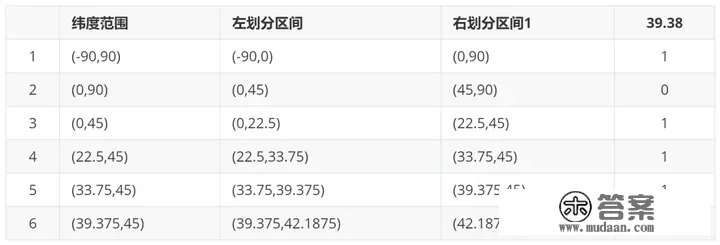

5.2 GeoHash

5.2 GeoHashGeoHash将地球做为为一个二维平面停止递归合成。每个合成后的子块在必然经纬度范畴内拥有不异的编码。以下图为例,那个矩形区域内所有的点(经纬度坐标)都共享不异的GeoHash字符串,如许既能够庇护隐私(只暗示大要区域位置而不是详细的点),又比力容易做缓存。

下面以一个例子来理解下那个算法,我们对纬度39.3817停止迫近编码 :

地球纬度区间是[-90,90],关于那个区间停止二分划分左区间[-90,0), 右区间[0,90]。39.3817属于右区间,标识表记标帜为1将右区间[0,90]继续停止划分,左区间[0,45) ,右区间[45,90]。39.3817属于左区间,标识表记标帜为0递归上面的过程,跟着每次迭代,区间[a,b]会不竭接近39.3817。递归的次数决定了生成的序列长度。关于经度做同样的处置。得到的字符串,偶数位放经度,奇数位放纬度,把2串编码组合生成新串。关于新串转成对应10进造查出现实的base32编码就是类似WX4ER的hash值。整体递归过程如下表所示:

那里有一篇文章详细介绍了GeoHash,有兴趣的同窗能够移步那里:

腾讯手艺工程:app 是若何快速定位我们位置的?深切领会 geohash 算法及其实现

5.3 布隆过滤器布隆过滤器被普遍用于黑名单过滤、垃圾邮件过滤、爬虫判重系统以及缓存穿透问题。关于数量小,内存足够大的情况,我们能够间接用hashMap或者hashSet就能够满足那个活动需求了。但是若是数据量十分大,好比5TB的硬盘上放满了用户的参与数据,需要一个算法对那些数据停止去重,获得活动的去重参与用户数。那种时候,布隆过滤器就是一种比力好的处理计划了。

布隆过滤器其实是基于bitmap的一种应用,在1970年由布隆提出的。它现实上是一个很长的二进造向量和一系列随机映射函数,用于检索一个元素能否在一个集合中。它的长处是空间效率和查询时间都远远超越一般的算法,缺点是有必然的误识别率和删除困难,次要用于大数据去重、垃圾邮件过滤和爬虫url记录中。核心思绪是利用一个bit来存储多个元素,通过如许的体例来削减内存的消耗。通过多个hash函数,将每个数据都算出多个值,存放在bitmap中对应的位置上。

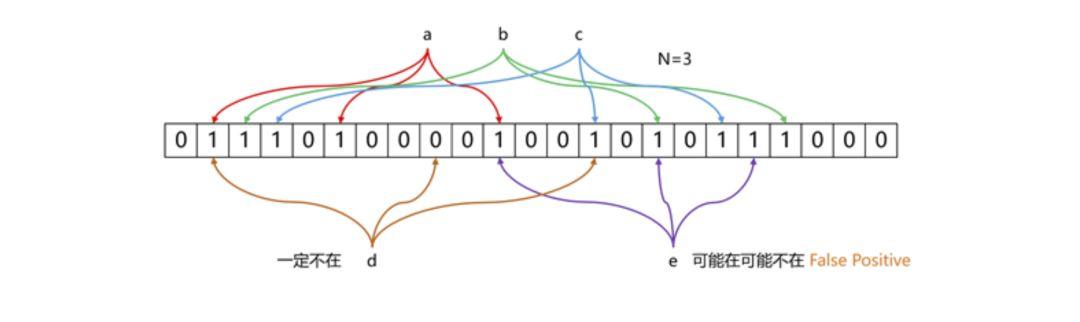

布隆过滤器的原理见下图所示:

上图所示的例子中,数据a、b、c颠末三次hash映射后,对应的bit位都是1,暗示那三个数据已经存在了。而d那份数据颠末映射后有一个成果是0,则表白d那个数据必然没有呈现过。布隆过滤器存在假阳率(断定存在的元素可能不存在)的问题,但是没有假阴率(判断不存在的原因可能存在)的问题。即关于数据e,三次映射的成果都是1,但是那份数据也可能没有呈现过。

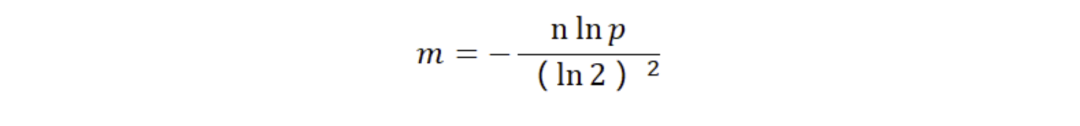

误判率的数据公式如下所示:

此中,p是误判率,n是包容的元素,m是需要的存储空间。由公示能够看出,布隆过滤器的长度会间接影响误报率,布隆过滤器越长其误报率越小。哈希函数的个数也需要权衡,个数越多则布隆过滤器 bit 位置位 1 的速度越快,且布隆过滤器的效率越低;但是若是太少的话,则会招致误报率升高。

6、总结Hash算法做为一种活动开发经常碰到的算法,我们在利用中不单单要晓得那种算法背后实正的原理,才能够在利用上做到有的放矢。Hash的相关常识还有良多,有兴趣的同窗能够继续深切研究。

更多内容欢送存眷我们:腾讯手艺工程